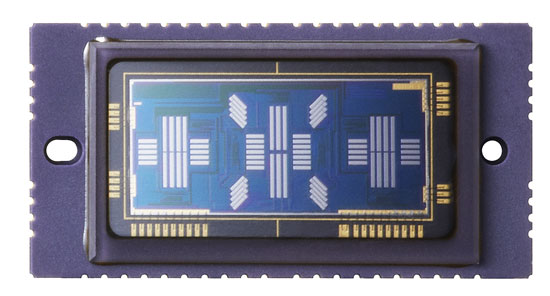

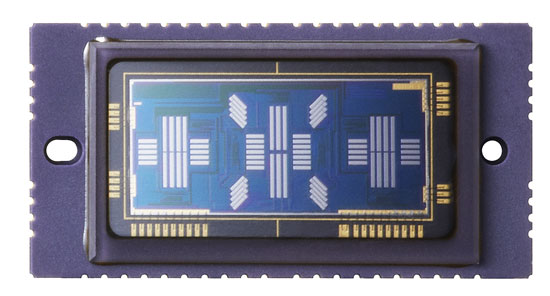

El enfoque automático de detección de fase funciona midiendo el desplazamiento horizontal entre los patrones de brillo proyectados en el sensor AF. Para medir el desplazamiento, se utilizan pares de matrices unidimensionales de píxeles monocromos. Así es como se ve el sensor AF en la Canon 5D mkIII:

Puede ver muchas líneas diferentes de píxeles utilizadas por diferentes puntos AF seleccionables por el usuario. En principio, podría usar líneas de píxeles en el sensor de imagen principal para hacer exactamente el mismo trabajo.

Este enfoque tiene algunas ventajas:

No tiene ningún problema si el sensor de imagen principal y el sensor AF están desalineados, ya que son uno y el mismo.

Evita la complejidad de los espejos secundarios y el costo del chip AF en sí.

Hay inconvenientes en el uso del sensor principal.

En un comentario debajo de la respuesta vinculada, se observa que el sensor de AF requiere una lente para enfocar los haces de luz en la ubicación adecuada del sensor, ya que es más pequeño que el sensor principal (la cursiva es mi propio supuesto)

Su suposición no es del todo correcta. No tiene que ver con tener un sensor AF más pequeño, las "lentes" AF son en realidad una lente con un perfil ondulado en forma de "B". Esta lente enfoca la luz proveniente de ambos lados de la lente en diferentes partes del sensor AF.

Aún necesitaría algún tipo de lente para hacer este trabajo al usar el sensor de imagen principal, y tendría que apartarse cuando toma una fotografía junto con el espejo reflejo, lo que requiere una disposición mecánica complicada dentro de la cámara. Este es el principal inconveniente de este enfoque, aunque existen otros obstáculos:

Los píxeles del sensor de imagen están detrás de los conjuntos de filtros de color que reducen la cantidad de luz que les llega hasta en dos tercios. Potencialmente, esto podría reducir el rendimiento con poca luz, sin embargo, le permitiría realizar la medición de fase en color para obtener menos resultados falsos (es menos probable que confunda un detalle desde el primer plano con un detalle desde el fondo, por ejemplo También se puede usar el color para ayudar al seguimiento).

El tamaño, el espacio y la sensibilidad de los píxeles serán diferentes entre los dos sensores, por lo que hacer ambos con un sensor significa que se deben hacer compromisos.

El sensor principal tendría que estar encendido por períodos mucho más largos, causando que se drene más energía de las baterías. Como Stan señala, el obturador también tendría que estar abierto durante la FA, por lo que cerrarlo antes de hacer la exposición introduciría un retraso.

Finalmente, los sensores de imagen digital de fecha previa de AF detectan por fase, de modo que toda la tecnología y las herramientas para realizar AF usando un sensor separado ya existe y está bien desarrollada.

Sin embargo los fabricantes han desarrollado un método ligeramente diferente para la fase detectar AF que hace usar el sensor principal. Fue desarrollado para cámaras sin espejo que no tienen la opción de un sensor AF dedicado y que tradicionalmente se han basado en el método de detección de contraste más lento utilizando el sensor principal.

En lugar de un par de lentes AF en la ruta de la luz para dirigir la luz desde cualquier lado del lente hacia diferentes partes del sensor AF, se pueden usar pares de microlentes regulares con mitades alternativas oscurecidas para obtener un efecto similar (píxeles a la izquierda medio blanco recibirá principalmente luz del lado derecho de la lente y viceversa).

Esto permite un enfoque AF híbrido utilizando una combinación de fase (para acercarse al enfoque correcto) y detección de contraste (para ajustar el resultado).