Los anteriores desafíos de golf de redes neuronales ( esto y aquello ) me inspiraron a plantear un nuevo desafío:

El reto

Encuentra la red neuronal feedforward más pequeño de tal manera que, dado cualquier vector 4-dimensional de entrada con las entradas de número entero en , las salidas de la red con Un error de coordenadas estrictamente menor que .

Admisibilidad

Para este desafío, una red neuronal de avance se define como una composición de capas . Una capa es una función que se especifica mediante una matriz de pesos , un vector de sesgos y una función de activación que se aplica coordenada- sabio:

Dado que las funciones de activación pueden ajustarse para cualquier tarea dada, necesitamos restringir la clase de funciones de activación para mantener este desafío interesante. Se permiten las siguientes funciones de activación:

Identidad.

ReLU.

Softplus.

Tangente hiperbólica.

Sigmoideo.

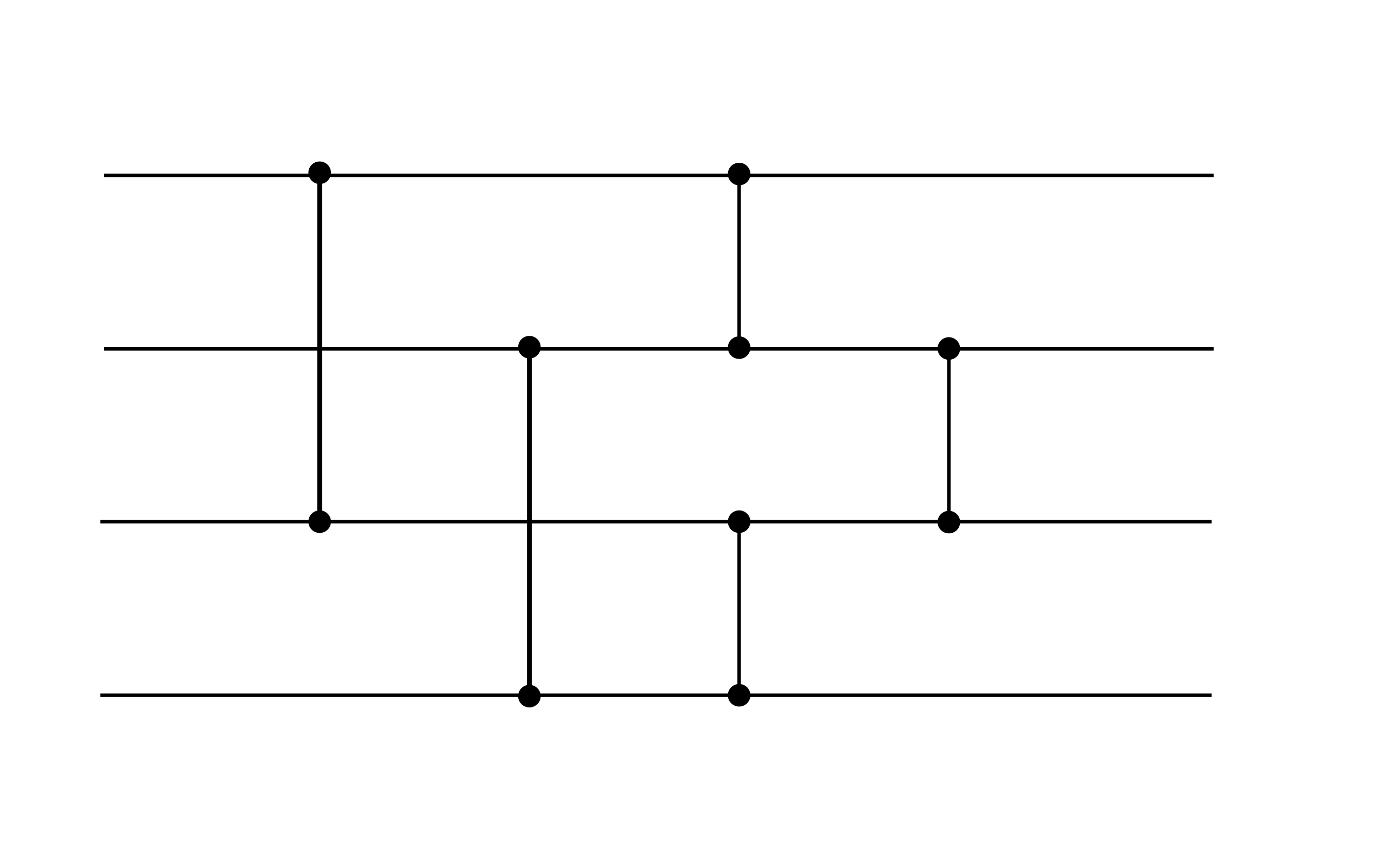

En general, una red neuronal admisible toma la forma para algunos , donde cada capa está especificada por los pesos , sesgos , y una función de activación de la lista anterior. Por ejemplo, la siguiente red neuronal es admisible (aunque no satisface el objetivo de rendimiento de este desafío, puede ser un gadget útil):

Este ejemplo exhibe dos capas. Ambas capas tienen sesgo cero. La primera capa usa activación ReLU, mientras que la segunda usa activación de identidad.

Puntuación

Tu puntaje es el número total de cero pesos y sesgos .

(Por ejemplo, el ejemplo anterior tiene una puntuación de 16 ya que los vectores de sesgo son cero).